Можно все, что не запрещено?

К каждому коммерческому предложению мы традиционно прикладываем аудит сайта. Без доработок, без приведения сайта в порядок не будет того эффекта от продвижения, на которое рассчитывает заказчик. Или вообще не будет эффекта. Почему? Расскажем и покажем наглядно. Начинаем цикл статей, посвященных аудиту.

Запрещаем не лезть, куда не следует

Первое, на что обращаем внимание и где часто совершаются ошибки – файл robots.txt

Robots.txt — текстовый файл, который содержит параметры индексирования сайта для роботов поисковых систем.

Именно в нем мы сообщаем поисковым системам о страницах, которые не нужно просматривать. А то ведь как? Они руководствуются правилом «Можно все, что не запрещено». Ну и выдают в поиске все, что нашли. Года два назад был скандал, когда в индекс поисковых систем попали страницы личного кабинета магазина для взрослых. Со списком купленных товаров. С контактами. И кто-то нашел. И выложил в открытый доступ. И началась травля. Людям звонили, к кому-то даже приезжали домой. А ведь всего-то надо было вебмастерам закрыть от индексации этот раздел…

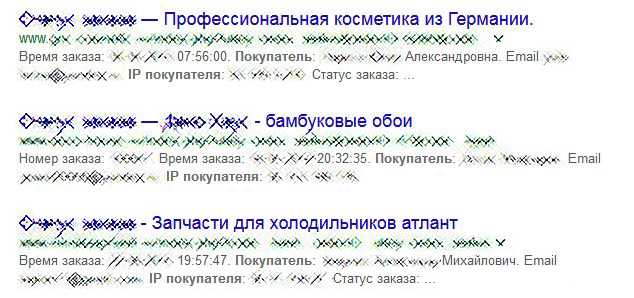

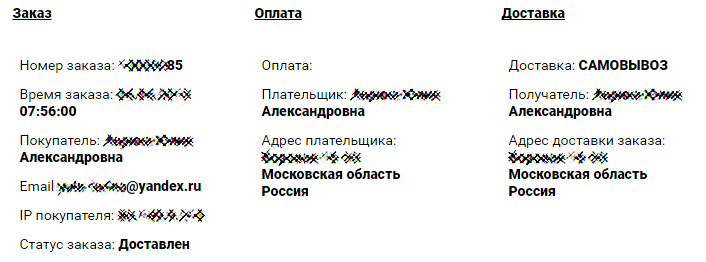

И ведь ничему никого жизнь не учит. До сих пор можно найти в поиске заявки на профессиональную косметику, бамбуковые обои, запчасти для холодильников, матрасы и рыболовные снасти. С указанием номера и даты заказа, ФИО и e-mail клиента, списком его покупок и адресом доставки. Из этических соображений заретушировали персональные данные.

Так что, первое – проверяем, чтобы было закрыто все, что смотреть и выкладывать не надо. Туда не только личный кабинет входит. Это и система редактирования, и результаты поиска, страницы регистрации и входа, версии для печати, страницы с результатами фильтрации и сортировки.

Кратко о том, на что еще обратить внимание. Это не приведет к таким печальным последствиям, как описано выше, но тоже необходимо.

Указан ли путь к файлу с описанием структуры сайта – sitemap.xml. О самом файле – в других темах.

Указано ли главное зеркало сайта в качестве значения директивы host.

При использовании протокола https указано ли это в файле robots.txt? Или забыли? Чаще всего забывают…

Также для всех роботов, кроме основных, рекомендуем указывать задержку между загрузками страниц через директиву crawl-delay.

Сомневаетесь, правильно ли заполнили свой robots.txt? Вы всегда сможете обратиться к нам за консультацией.

Как говорится у Яндекса, robots.txt – предохраняйтесь!

Комментировать